選挙を「歪める」のは誰か

2010年代の中頃に「新興技術」の概念が注目されるようになった際、そこには「技術発展の見通しの不明瞭さ」や、それに伴って生じる「社会的影響の不確実性」への懸念があった。そうした中、急速な発展と普及を見せた技術分野では、リスクの実態がかなりの程度具体的に論じられるようになり、規制をめぐる議論が飛躍的に進むようになった。

情報通信関連の新興技術が民主主義にもたらすリスクには、大きく分けて二つのパターンがある。ひとつは、外国政府による影響力行使の問題である。2016年米国大統領選挙の際、民主党のヒラリー・クリントン候補に対してロシアから干渉があったことが大きな話題となった。これは情報通信技術の発展が外部からの脅威を招来したケースのひとつである。2023年9月にマイクロソフトが発表した報告書では、中国がサイバー空間を通じて他国の社会や選挙プロセスに介入するようになっており、近年ではそこで生成AIに基づくコンテンツが利用されていることも指摘されている。これらは政治体制という各国固有の「価値」が外部から脅かされている点で、まさに国家安全保障の問題といってよい。

もうひとつ、近年より注目を集めているのが、新興技術の発展によって選挙に対するリスクが国内で発生するようになっていることである。歪曲された情報や誤解に基づく言説は常に外国からやってくるとは限らず、国内からも発信され、サイバー空間を通じて容易に拡散される。また、情報歪曲のようなかたちをとらずとも、デジタルゲリマンダリング(情報技術やデータをもとに選挙区を恣意的に設定したり、投票行動を偏向させたりすること)のようなかたちで選挙の恣意的な制御が起こることも懸念されている。これらの技術の利用と規制のあり方をめぐる議論は、各国が自国の政治制度をどのように捉え、内生する社会リスクをいかにして管理するかという問題でもある。

生成AI―国内の選挙プロセスで投げかけられる「技術の使い方」の問題―

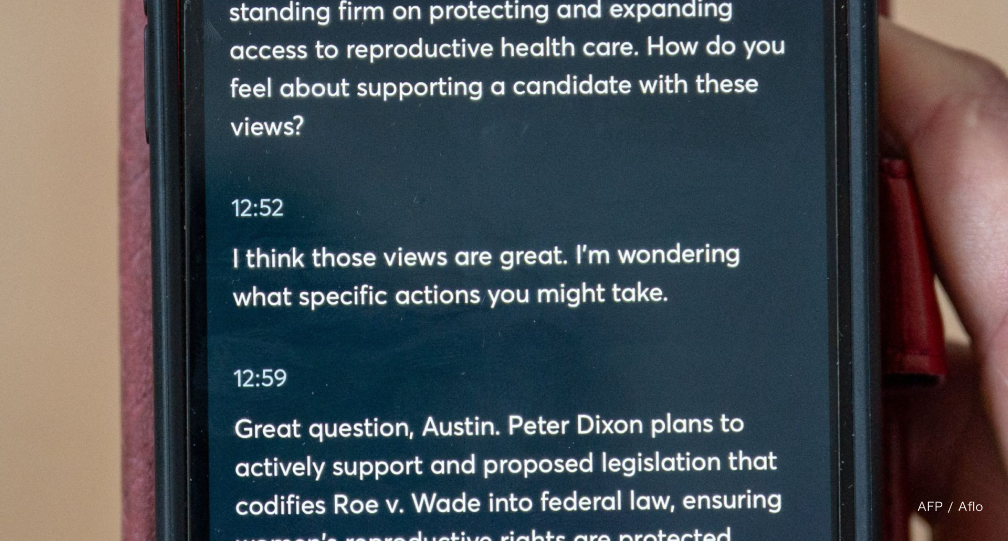

この一年間で民主主義に対する悪影響が最も懸念されるようになった技術は生成AIである。そこでは、これまでしばしば議論されてきた「AIが人の手を離れて自律的にふるまい、あるいは意図せざる結果をもたらす」ことの問題だけでなく、「AIを人が使う」際に生じるリスクが懸念される。

現段階では候補者(陣営)自身が積極的に生成AIを用いた情報発信を行うこともある。2023年の4月に共和党全国委員会がYouTubeで公開した動画は、バイデン大統領が再選することによって生じる国際不安や金融危機を「イメージ」したものであった。この動画ページの下部には「2024年にジョー・バイデンが再選された場合にこの国に起こりうる未来をAIで生成したもの」との注釈が「明記」されており、現在(2024年3月4日)も削除されていない。確かにこのコンテンツは、将来を想像したものであって、事実を歪曲したものではないが、生成AIを用いた世論誘導の一例ではあろう。

とはいえ、こうした生成AIの使い方は、従来のメディアを通じたネガティブキャンペーンの延長線上にあるとも言える。むしろ選挙への影響という文脈でより大きな懸念をもたらしているのが、匿名による不確実な情報の流布である。たとえば、2023年のトルコ大統領選挙では現職のエルドアン氏が再選されたが、その際に対抗候補がディープフェイクによって印象操作されたことが問題となった。また、同年9月のスロヴァキア議会選挙では、投票直前に生成AIで操作されたとみられる音声が拡散したことも注目を集めた。直近では米国大統領選において、生成AIを用いてバイデン大統領の声を模した自動電話が民主党支持者に予備選への投票を控えるよう呼びかけ、調査が行われるという事案が発生している。このような情報歪曲の影響下で有権者の意思決定が行われることになれば、選挙が信じられなくなる。

共同規制の推進

多くの人々が匿名、真偽不明、そしてセンセーショナルな情報に飛びつくリスクが広く認識されていながら、その有用性ゆえに生成AIを使わないという選択肢はもはや議論されない。だからこそ、今日の課題はサイバー空間で流布される情報の信頼性をいかに担保するかという点に据えられている。

選挙年を迎えて民間企業がリスク管理のための自主規制に乗り出したことは、今後の規制のあり方を考えるうえで重要なポイントである。2023年初頭にはオープンAIやメタが相次いで自社技術の政治利用を禁止するなどの対策を表明しはじめた。その後、7月にバイデン政権はAI大手企業による自発的なリスク管理の約束を取り付け、さらにこの合意を踏まえて10月には「安全・安心・信頼できるAIに関する大統領令」を発出した。この大統領令は、政府が規制の方向性を示しつつ、規制の実行者である民間企業とのコンセンサスに基づいている点で、共同規制(co-regulation)モデルの典型ともいえる。

国際的に見れば、中国も含めた規制の検討が進んでいることは重要である。選挙におけるAIを用いた情報歪曲への問題意識は、2023年にイギリスで開催されたAI安全サミットでも確認されており、規制の方向性にはいわゆる同志国の間だけでなく、中国も含めて大まかなコンセンサスがある。また、企業レベルでもグローバルなリスク対応が進んでいる。2024年2月には、生成AIの悪用による選挙戦への影響を防止するために、世界の主要なIT企業20社が共同で、検知ツールの開発や電子透かしの埋め込みといった対応を進めることに合意した。そこには米国企業だけでなく、中国共産党との関係がしばしば懸念されるTikTokも参加している。並行して、AI Safety Institute Consortiumのもとで200社以上の連携によるリスク管理・安全性等への対応も合意された。生成AIへの規制は、このように政治体制を問わず国境をまたいで、そして官民が協働するかたちで進められつつある。

国際規制における利害は対称的か?

しかし果たして、民主主義国家と権威主義国家は同一のリスクに直面しているのだろうか。確かに、AIを用いて選挙が歪められれば、それはとりわけ民主主義という政治体制において大きなリスクとなる。他方、生成AIのような技術は、中国においても政権批判のツールとなることが懸念されており、そこには一定の規制に向けたインセンティブが存在する。同様の技術が政治体制の違いによって異なるリスクとして受け止められることになるのである。

もし、民主主義国家と権威主義国家が生成AIのような技術をかたちは違えど同様にリスクと捉えるのであれば、そこには協調的な規制形成の可能性がある。ただし、同じく政治体制の違いゆえに、協力によるベネフィットもまた非対称なものになりうることには注意する必要があろう。民主主義国家においては自由を守るための技術規制となりうる措置が、権威主義体制下では政府にとって好ましくない表現や報道の自由を過度に制限するルールにもなりうるのである。

もっとも、民主主義国家の間でもAI規制をめぐる認識が常に一致するわけではないだろう。サイバー空間や生成AIが民主主義にもたらすリスクは「正しく」管理されるべきである。このような共通了解は成立している一方、個人の権利や民主主義の捉え方は一様ではない。守るべきものの解釈にズレがあるならば、それは各国の技術動向や産業構造の違いとあいまって、具体的な履行ルールの形成に際して摩擦を引き起こす可能性がある。

日本の課題

日本の状況はどうか。広島AIプロセスを主導し、イギリスのAI安全サミットにおける合意形成を支持するなど、AI規制に積極的な立場をとっていることは確かである。反面、国内レベルでは米国や欧州が国内・域内の規制強化を先行して進めているのに対して、日本ではこれまで最も懸念の高まっているAI分野においても国内規制の構築でやや後れを取ってきた。そうした中で、日本でも2024年の成立に向けて「AI推進基本法」の議論が進んでいることは、自国の民主主義観や技術的背景を踏まえて規制形成に参加し、国際レベルの規制論議と日本国内の規制枠組みを一致させるための重要な取り組みとなる。

選挙への影響という点では、日本では岸田首相のディープフェイクなどは話題になったものの、幸か不幸か、選挙結果に直接影響するような具体的事案はまだ報道されていない。しかし技術的な面では、国産LLM(大規模言語モデル)の開発に向けた取り組みが官民で進められていることが大きな影響をもたらすかもしれない。現在の日本では、英語圏のLLMに依存した生成AIの利用が主流となっている。日本語主体のLLMの普及が進めば、日本社会におけるAI利用は加速する一方、リスクのあるコンテンツも増加する。また、これまで日本語話者には「不自然」に見えていたコンテンツが、「より自然」なかたちで流布されることになり、操作された情報を見破りにくくなるといったリスクも高まるかもしれない。

多くの国にとってそうであるように、日本でも生成AIを含む新興技術の利用は加速しているが、その普及が進むほど、選挙におけるリスクの問題にも当事者として向き合わなければならなくなる。国内外の規制形成を着実に進め、健全な情報空間を構築することは、単に技術の使い方を決めるための作業にとどまらない。それはわれわれの民主主義はどうあるべきか、という問題に向き合うことも意味するのである。